Python 分布爬虫的数据去重与清洗秘籍

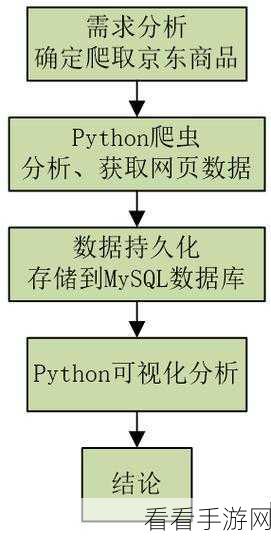

在当今数字化的时代,数据的获取和处理变得至关重要,而 Python 分布爬虫作为一种强大的数据采集工具,其数据去重与清洗环节更是决定着后续数据分析和应用的质量。

Python 分布爬虫在数据采集过程中,往往会面临大量重复和杂乱的数据,有效的数据去重与清洗能够提高数据的准确性和可用性,为后续的工作打下坚实基础。

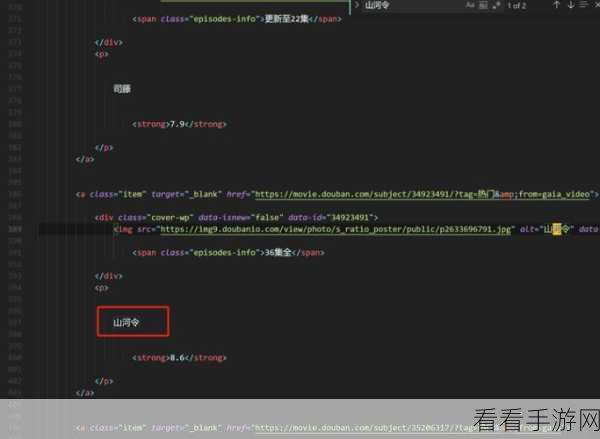

如何实现 Python 分布爬虫的数据去重与清洗呢?我们可以利用哈希算法来进行数据去重,通过对采集到的数据计算哈希值,相同数据的哈希值相同,从而快速判断并去除重复数据,对于数据清洗,可以运用正则表达式来筛选和处理不符合规则的数据,去除无效的字符、修正格式错误等,还可以结合数据的特征和业务需求,制定特定的过滤规则,进一步提高数据的质量。

在实际操作中,还需要注意数据的完整性和一致性,对于缺失值,要根据具体情况进行填充或删除处理,要对清洗后的数据进行验证和复查,确保数据的准确性和可靠性。

掌握 Python 分布爬虫的数据去重与清洗技巧,能够让我们在数据处理的道路上更加得心应手,为获取有价值的信息提供有力保障。

文章参考来源:相关技术论坛及专业书籍。