破解 Hive ClusterBy 数据倾斜难题,攻略秘籍大公开

在当今的大数据处理领域,Hive 的 ClusterBy 操作常常会遭遇数据倾斜的困扰,这不仅影响了数据处理的效率,还可能导致整个任务的失败,究竟应该如何应对这一棘手的问题呢?

数据倾斜产生的原因多种多样,首先是数据本身的分布不均,某些值出现的频率过高;其次是业务逻辑的复杂性,导致某些特定的计算操作集中在少数的数据分区上;硬件资源的不均衡分配也可能成为引发数据倾斜的因素。

解决 Hive ClusterBy 数据倾斜问题,我们可以从多个方面入手,调整数据的分布是一种有效的方法,通过对数据进行预处理,将分布不均的数据进行重新分区或者采样,使得数据在各个分区上的分布更加均匀。

优化业务逻辑也是关键的一环,重新审视和优化计算逻辑,避免不必要的复杂操作集中在少数数据上,能够有效地减轻数据倾斜的程度。

合理配置硬件资源同样不容忽视,根据数据处理的需求,合理分配计算资源和存储资源,确保各个节点能够均衡地承担任务,从而减少数据倾斜带来的影响。

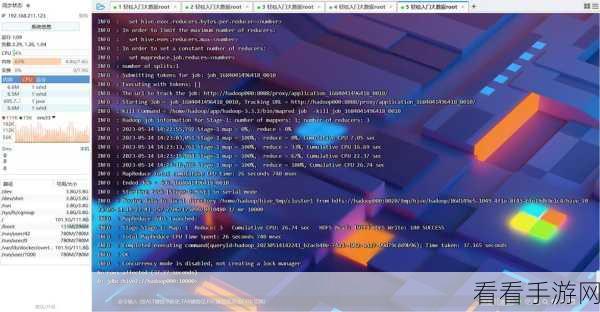

还可以采用一些特定的 Hive 配置参数来应对数据倾斜,比如调整 MapReduce 的相关参数,以优化任务的执行过程。

处理 Hive ClusterBy 数据倾斜问题需要综合考虑多个因素,并采取针对性的措施,只有这样,才能确保数据处理的高效和稳定。

参考来源:大数据处理相关技术文献及实践经验总结。

仅供参考,您可以根据实际需求进行调整和修改。