掌握 Python 爬虫代码优化秘籍,让数据抓取更高效

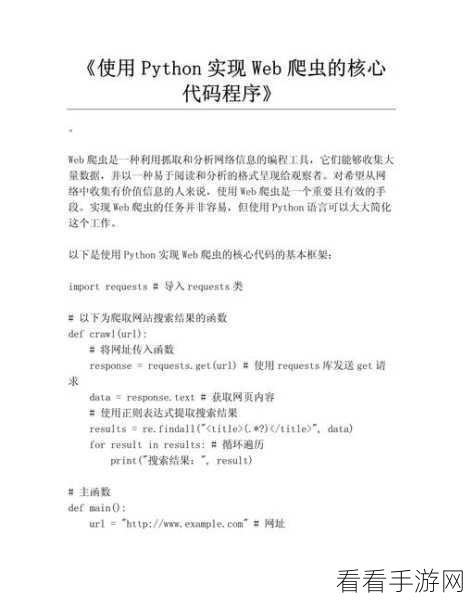

在当今数字化时代,Python 爬虫成为获取大量数据的重要工具,许多开发者在编写爬虫代码时,常常面临优化的难题,如何让爬虫代码更加高效、稳定且准确地抓取数据呢?我们将为您详细介绍 Python 爬虫代码的优化方法。

中心句:Python 爬虫在获取数据方面重要,但代码优化存在难题。

要优化 Python 爬虫代码,我们首先需要对代码结构进行精心设计,清晰、简洁且具有良好可读性的代码结构能够极大地提高代码的可维护性和可扩展性,避免过度复杂的逻辑嵌套,合理划分函数和模块,使得每个部分的功能单一且明确,这样,在后续的调试和修改中,能够更加迅速地定位问题并进行处理。

中心句:优化 Python 爬虫代码需精心设计代码结构,保证其清晰简洁、可读性高。

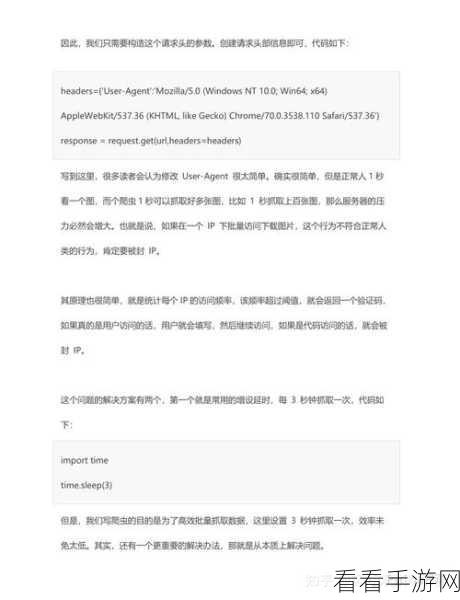

优化网络请求也是关键的一环,在进行爬虫操作时,要合理设置请求头,模拟真实的浏览器行为,以降低被目标网站识别为爬虫而封禁的风险,控制请求的频率,避免过于频繁的请求给服务器带来过大压力,导致被限制访问。

中心句:优化网络请求是 Python 爬虫代码优化的关键,包括设置请求头和控制频率。

数据存储的优化不容忽视,选择合适的数据存储方式,如使用数据库或者高效的文件格式,能够提高数据的读写效率,对于大规模数据,合理的索引和分区策略能够加快数据的查询和处理速度。

中心句:数据存储的优化对 Python 爬虫代码很重要,要选合适方式和策略。

错误处理和异常捕获机制的完善也是必不可少的,在爬虫过程中,可能会遇到各种网络异常、服务器错误等情况,通过完善的错误处理机制,能够确保爬虫在遇到问题时不会崩溃,而是能够记录错误信息,进行适当的重试或者采取其他应对措施,保证爬虫的持续稳定运行。

中心句:完善错误处理和异常捕获机制,确保 Python 爬虫稳定运行。

优化 Python 爬虫代码需要综合考虑多个方面,从代码结构、网络请求、数据存储到错误处理,每一个环节都需要精心打磨,只有这样,才能打造出高效、稳定且可靠的爬虫程序,为您的数据获取工作提供有力的支持。

参考来源:相关技术文档及行业经验总结。