探秘,Flink 与 Kafka 数据可视化的奇妙之旅

在当今数字化的时代,数据的处理和可视化成为了关键的环节,特别是 Flink 和 Kafka 这两个强大的工具,如何实现它们的数据可视化更是备受关注。

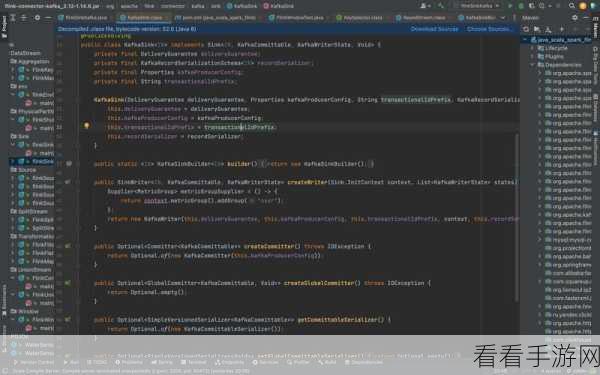

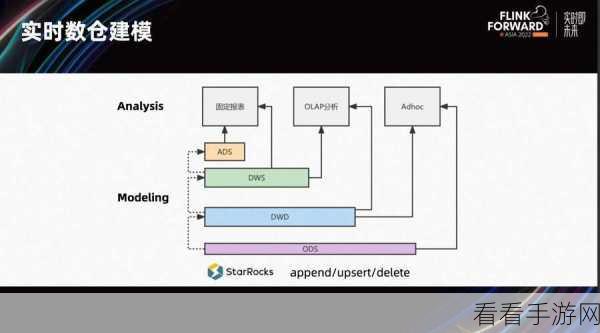

Flink 和 Kafka 是大数据处理领域中常用的技术框架,Kafka 作为分布式消息队列系统,能够高效地处理和传递大量的数据,而 Flink 则是一个优秀的流处理框架,具备强大的实时处理能力。

要实现 Flink 和 Kafka 的数据可视化,第一步需要明确数据的来源和类型,了解数据是从哪些环节产生,是结构化数据还是非结构化数据,这对于后续选择合适的可视化工具至关重要。

选择适合的可视化工具是关键,市面上有众多的可视化工具可供选择,如 Tableau、PowerBI 等,这些工具各有特点和优势,需要根据具体的需求和数据特点来决定。

在数据处理阶段,需要对从 Flink 和 Kafka 中获取的数据进行清洗和转换,去除无效数据、统一数据格式,以便能够更好地展示和分析。

而在可视化的设计方面,要注重布局的合理性和美观性,清晰的图表结构、醒目的颜色搭配,都能让数据的呈现更加直观和易懂。

还需要考虑用户的交互体验,提供筛选、排序、钻取等功能,让用户能够根据自己的需求灵活地探索数据。

实现 Flink 和 Kafka 的数据可视化并非一蹴而就,需要综合考虑多个方面的因素,从数据的获取到处理,再到可视化的设计和用户体验,每一个环节都需要精心打磨,才能打造出令人满意的数据可视化效果。

文章参考来源:大数据处理相关技术文档及实践经验。