突破!Hive 与 Spark 集成的艰难险阻与应对策略

Hive 和 Spark 集成,这是大数据领域中一个极具挑战性的任务,在当今数字化时代,数据处理和分析的需求日益增长,Hive 和 Spark 作为强大的工具,它们的集成成为众多开发者和企业关注的焦点,这一集成过程并非一帆风顺,充满了各种难题和挑战。

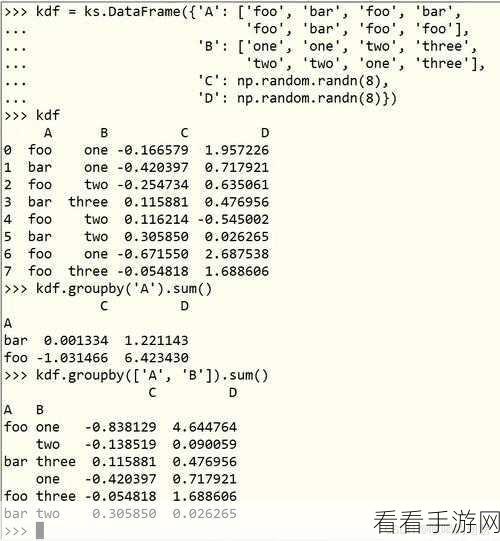

Hive 和 Spark 集成面临的首要问题是数据兼容性,由于两者的数据存储和处理方式存在差异,导致在集成过程中数据的转换和迁移可能出现错误或丢失,Hive 中的表结构和数据类型在 Spark 中可能无法直接对应,需要进行复杂的映射和转换操作。

性能优化的挑战,Hive 通常适用于大规模数据的批处理,而 Spark 则在实时处理和迭代计算方面表现出色,在集成时,如何合理分配计算资源,充分发挥两者的优势,以提高整体性能,是一个需要深入研究和实践的问题。

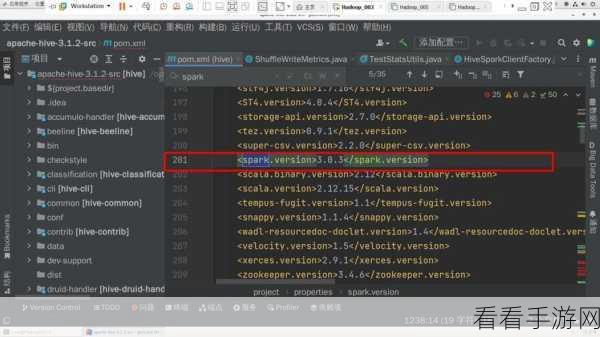

版本兼容性也是不容忽视的,不同版本的 Hive 和 Spark 可能存在接口和功能的差异,这会给集成带来诸多不确定性,开发者需要对两者的版本进行仔细选择和匹配,以确保集成的稳定性和可靠性。

为了应对这些挑战,开发者们可以采取一系列措施,要深入了解 Hive 和 Spark 的技术架构和特点,明确两者的优势和适用场景,在此基础上,制定合理的数据迁移和转换策略,确保数据的完整性和准确性。

进行性能调优是关键,通过调整配置参数、优化算法和数据结构等方式,充分发挥 Hive 和 Spark 的性能潜力,利用监控工具实时监测系统的运行状态,及时发现和解决性能瓶颈。

保持对 Hive 和 Spark 版本的关注,及时更新和升级,以适应新的需求和解决可能出现的兼容性问题。

Hive 和 Spark 的集成虽然充满挑战,但只要我们深入理解、精心规划和不断实践,就一定能够克服困难,实现两者的完美结合,为大数据处理和分析带来更强大的动力。

文章参考来源:大数据技术相关研究及实践经验。