深度解析,Flink 与 Kafka 数据转换的精妙之道

在当今数字化的时代,数据处理和转换成为了众多企业和开发者关注的焦点,Flink 和 Kafka 作为强大的数据处理工具,它们之间的数据转换方式具有重要的研究价值。

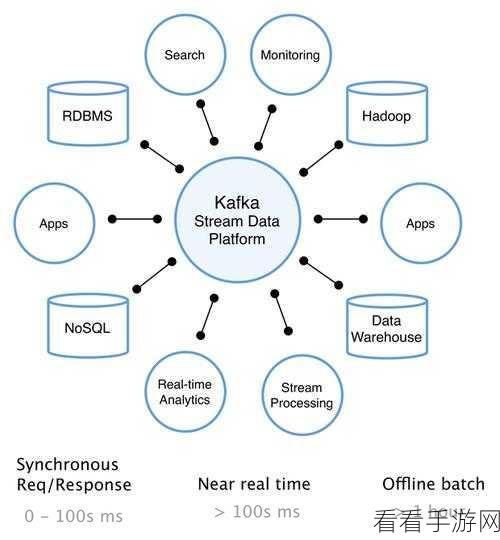

Flink 是一个出色的流处理框架,能够实现高效的实时数据处理,而 Kafka 则是分布式的消息队列系统,常用于数据的存储和传递。

要实现 Flink 和 Kafka 的数据转换,关键在于理解它们的工作原理和交互方式,需要明确数据的输入和输出格式,确保两者之间的兼容性,对于文本数据,需要确定字符编码、分隔符等细节。

配置正确的连接参数也是至关重要的,包括 Kafka 的主题名称、分区信息,以及 Flink 的任务并行度等。

还需要考虑数据的转换逻辑,这可能涉及到数据清洗、格式转换、字段提取等操作,通过合理编写 Flink 的处理函数,可以实现对数据的精准转换。

在实际应用中,还需要注意错误处理和容错机制,当数据转换过程中出现异常时,能够及时捕获并进行相应的处理,以保证系统的稳定性和可靠性。

掌握 Flink 和 Kafka 之间的数据转换并非一蹴而就,需要深入了解它们的特性,并结合实际业务需求进行不断的实践和优化。

参考来源:相关技术文档及行业实践经验。