探秘 Spark 算法容错的神秘技巧

Spark 算法在处理大规模数据时,容错机制至关重要,想要深入了解 Spark 算法如何进行容错,那就跟随我的脚步一同探索。

Spark 算法的容错之所以关键,是因为在实际应用中,数据处理过程可能会面临各种意外情况,比如硬件故障、网络延迟、节点宕机等,这些都可能导致数据丢失或处理中断,如果没有有效的容错机制,整个计算任务可能会失败,从而造成时间和资源的极大浪费。

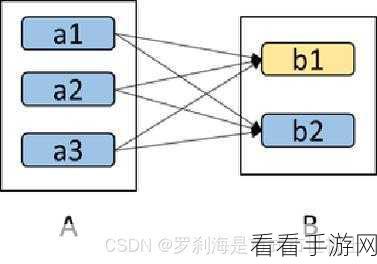

Spark 算法实现容错主要依靠两种核心策略,其一是数据的备份与恢复,在数据处理之前,Spark 会将数据进行多份备份,并存储在不同的节点上,这样,当某个节点出现故障时,可以从其他节点获取备份数据进行恢复,继续完成计算任务,其二是检查点机制,在关键计算阶段设置检查点,将中间结果保存下来,一旦出现故障,可以从最近的检查点重新开始计算,避免从头再来,大大提高了计算效率。

为了更好地理解 Spark 算法的容错,我们来看一个具体的例子,假设我们正在进行一个大规模的数据分析任务,涉及到数十亿条数据的处理,在计算过程中,某个节点突然宕机,由于事先采用了数据备份策略,系统能够迅速从其他正常节点获取相同的数据,并分配给空闲的计算资源继续处理,确保任务不受太大影响,通过检查点机制,已经完成的部分计算结果得以保存,故障恢复后可以接着之前的进度继续计算,而不是重新开始整个流程。

在实际应用中,合理配置 Spark 算法的容错参数也是非常重要的,这需要根据具体的业务需求、数据规模和计算环境来进行调整,备份数据的份数、检查点的设置间隔等参数,都需要经过仔细的考量和测试,以达到最佳的容错效果和计算性能。

掌握 Spark 算法的容错机制对于提高数据处理的可靠性和效率具有重要意义,只有深入了解并灵活运用这些容错策略,才能在复杂的计算环境中应对各种挑战,确保计算任务的顺利完成。

文章参考来源:相关技术文档及专业研究资料。