探秘高级 Python 爬虫数据清洗的技巧与策略

Python 爬虫在获取大量数据的同时,如何有效地清洗这些数据成为关键,高级 Python 爬虫数据清洗并非易事,需要掌握一系列技巧和方法。

数据清洗是数据处理中的重要环节,在爬虫获取的数据中,往往存在着各种杂质和错误,比如重复的数据、缺失的值、格式不一致等等,若不进行清洗,这些问题数据将会影响后续的分析和应用。

要做好高级 Python 爬虫数据清洗,得明确清洗的目标和原则,首先要确定清洗后的数据应达到何种质量标准,比如准确性、完整性和一致性,然后遵循一些基本原则,如尽量保留原始数据的有用信息,避免过度清洗导致数据丢失重要特征。

选择合适的清洗工具和技术至关重要,Python 提供了丰富的库和函数用于数据清洗,Pandas 库就是常用的利器,通过它,可以轻松处理数据的读取、筛选、转换和清理等操作。

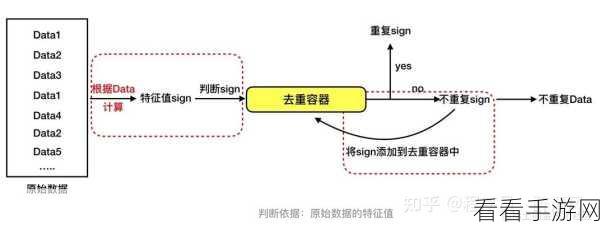

在清洗过程中,处理重复数据是常见的任务,可以通过比较关键字段,识别并删除重复的记录,以保证数据的唯一性。

对于缺失值的处理也需要谨慎,可以根据数据的特点和业务需求,选择合适的方法填充缺失值,比如使用平均值、中位数或者基于模型的预测值。

格式不一致的问题同样不容忽视,要将数据统一为规范的格式,便于后续的处理和分析。

高级 Python 爬虫数据清洗是一个复杂但必要的工作,只有掌握了正确的方法和技巧,才能从海量的爬虫数据中提取出有价值、高质量的数据,为进一步的分析和应用打下坚实的基础。

参考来源:相关 Python 爬虫数据清洗的技术文档和实践经验总结。