Python 爬虫 requests 常见请求失败原因大揭秘

Python 爬虫中的 requests 库是常用工具,但有时会遭遇请求失败的困扰,这究竟是何原因?且让我们一同深入探究。

导致 Python 爬虫 requests 请求失败的因素众多,网络连接不稳定是常见原因之一,若网络出现波动、中断或延迟过高,都可能致使请求无法成功发送或接收响应。

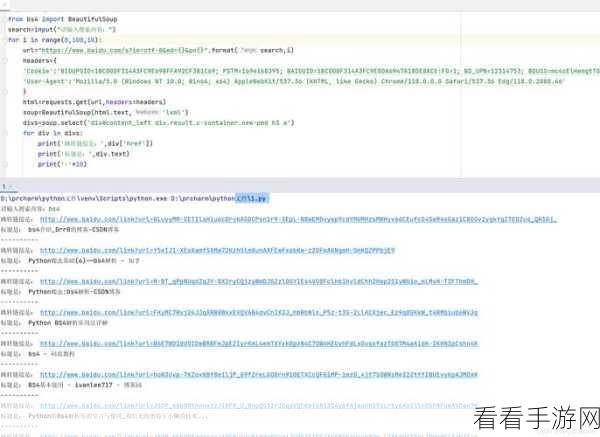

请求参数设置错误也不容忽视,未正确设置请求头中的 User-Agent、Referer 等信息,或者请求方法(GET、POST 等)选择不当,都可能被服务器识别为异常请求而拒绝响应。

服务器端的限制同样会导致请求失败,部分网站会设置反爬虫机制,如访问频率限制、IP 封禁等,一旦触发这些限制,requests 请求就会失败。

代码逻辑错误也可能是罪魁祸首,在处理请求响应时,如果没有正确处理异常情况,或者对响应数据的解析出现错误,都可能导致整个请求流程无法正常完成。

要解决 requests 请求失败的问题,首先需要确保网络连接的稳定性,可以通过检查网络设备、更换网络环境等方式来解决。

要仔细检查请求参数的设置,确保符合目标网站的要求,了解目标网站的反爬虫策略,合理控制请求频率,避免被封禁。

在编写代码时,要严谨处理各种异常情况,保证代码的逻辑正确性,通过以上方法,相信能有效解决 Python 爬虫 requests 请求失败的问题,让您的爬虫之旅更加顺畅。

文章参考来源:个人多年的 Python 爬虫开发经验总结。