探索 Hadoop 与 Spark 的完美集成之道

Hadoop 和 Spark 作为大数据领域的重要技术,它们的集成一直是众多开发者关注的焦点。

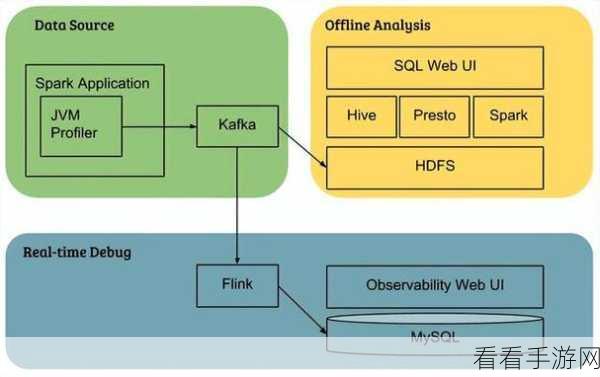

Hadoop 以其强大的分布式存储能力而闻名,能够处理海量的数据,Spark 则凭借出色的计算性能,在数据处理速度上展现出独特优势,将两者集成,能够实现优势互补,为大数据处理带来更高效的解决方案。

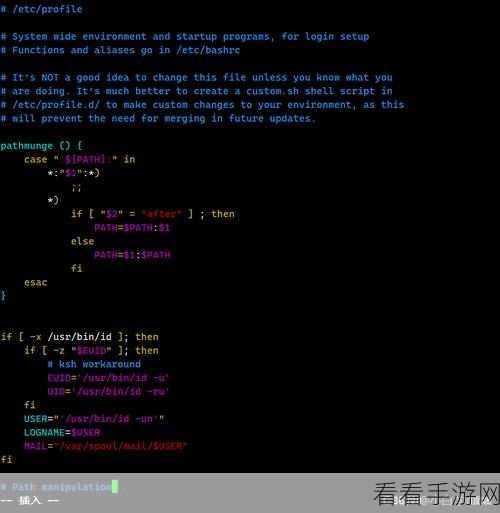

要实现 Hadoop 与 Spark 的集成,需要了解它们的架构和工作原理,Hadoop 的核心组件包括 HDFS(分布式文件系统)、YARN(资源管理框架)等,Spark 则有 Spark Core、Spark SQL 等重要模块。

在实际集成过程中,配置环境是关键的一步,需要确保 Hadoop 和 Spark 的版本兼容,并正确设置相关的配置参数,比如内存分配、核心数量等。

数据的迁移和转换也是集成中的重要环节,要将 Hadoop 中的数据顺利地导入 Spark 进行处理,需要选择合适的数据格式和转换方法。

还需要考虑任务的调度和资源的分配,通过合理的调度策略,能够充分利用 Hadoop 和 Spark 的资源,提高整个系统的运行效率。

Hadoop 与 Spark 的集成并非一蹴而就,需要开发者深入了解它们的特性,精心进行配置和优化,才能发挥出两者的最大潜力,为大数据处理带来更出色的表现。

文章参考来源:大数据技术相关专业书籍及技术论坛。