探秘 Spark 算法处理实时数据的神奇魔法

在当今数字化的时代,数据的处理速度和实时性变得至关重要,Spark 算法作为一种强大的数据处理工具,在处理实时数据方面展现出了独特的优势。

Spark 算法之所以能够出色地处理实时数据,关键在于其高效的内存计算和优化的架构设计,它能够快速地对大量数据进行实时分析和处理,为企业和开发者提供了强大的支持。

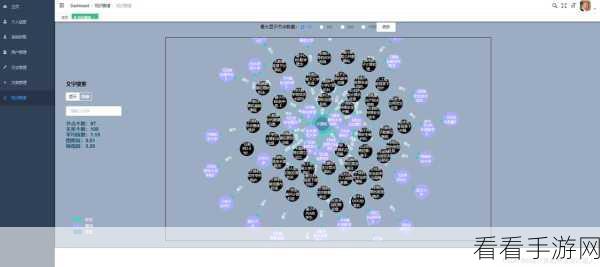

Spark 算法具体是如何实现对实时数据的处理呢?它采用了分布式计算的模式,将数据分布在多个节点上进行并行处理,大大提高了处理效率,Spark 算法具备出色的缓存机制,能够将经常使用的数据缓存到内存中,减少数据读取的时间开销,它还支持实时流处理,可以对源源不断的实时数据进行实时计算和分析。

为了更好地理解 Spark 算法处理实时数据的过程,我们可以通过一个实际的案例来进行说明,假设我们有一个电商平台,需要实时分析用户的浏览行为和购买意向,通过 Spark 算法,我们可以实时采集用户的浏览数据、点击数据和购买数据,并利用其强大的计算能力和分析功能,快速得出用户的兴趣偏好和购买趋势,从而为商家提供精准的营销策略和推荐服务。

在实际应用中,要充分发挥 Spark 算法处理实时数据的优势,还需要注意一些问题,数据的质量和准确性对于算法的效果有着重要的影响,在数据采集和预处理阶段,需要确保数据的完整性和准确性,算法的参数调整和优化也是至关重要的,需要根据具体的业务场景和数据特点进行合理的配置。

Spark 算法在处理实时数据方面具有巨大的潜力和优势,通过深入了解其工作原理和应用方法,我们能够更好地利用这一工具,为各种业务场景提供高效、准确的数据处理和分析服务。

参考来源:相关技术文献及行业研究报告。