探秘 Spark 算法,大规模数据处理的神奇魔法

在当今数字化时代,数据的规模呈爆炸式增长,如何高效处理这些海量数据成为了关键挑战,而 Spark 算法在这一领域展现出了卓越的能力。

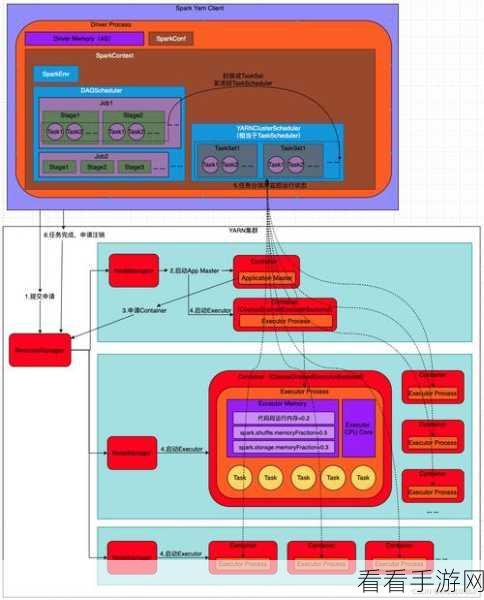

Spark 算法之所以能够出色地处理大规模数据,得益于其独特的设计和强大的功能,它采用了分布式计算框架,能够将数据分散到多个节点上进行并行处理,从而大大提高了数据处理的速度和效率。

Spark 算法具有多种优化策略,以应对大规模数据处理中的各种问题,它能够通过数据缓存机制,将经常使用的数据存储在内存中,减少数据的读取时间,它还支持多种数据格式和数据源,使得数据的导入和处理更加便捷。

在实际应用中,使用 Spark 算法处理大规模数据需要合理配置资源,要根据数据量和计算需求,确定合适的节点数量和内存分配,还需要对算法的参数进行调优,以达到最佳的性能。

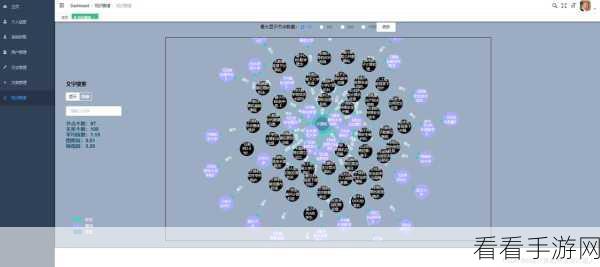

为了更好地发挥 Spark 算法的优势,还需要结合其他技术和工具,与数据仓库技术相结合,可以实现更高效的数据存储和管理;与机器学习算法相结合,可以进行大规模的数据挖掘和分析。

Spark 算法为大规模数据处理提供了强大的支持,但要充分发挥其潜力,需要深入理解其原理和特点,并在实践中不断探索和优化。

参考来源:相关技术文档和行业研究报告。