探索 Hadoop 与 Spark 集成的挑战与应对策略

Hadoop 和 Spark 作为大数据领域的重要技术,它们的集成一直是开发者关注的焦点,集成这两者究竟难度如何?又该如何应对其中的挑战?

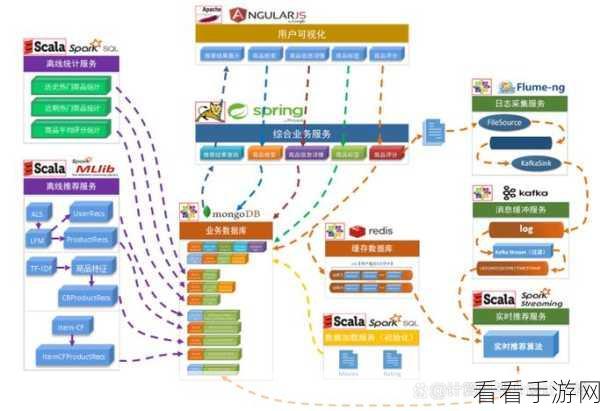

Hadoop 是一个分布式系统基础架构,具有可靠、高效、可伸缩的特点,而 Spark 则是一种快速通用的大数据计算引擎,它们的集成可以带来更强大的数据处理能力,但也并非一帆风顺。

集成 Hadoop 与 Spark 面临着诸多技术难题,首先是数据格式的兼容性,Hadoop 常用的文件格式如 HDFS 与 Spark 支持的格式可能存在差异,这需要进行格式转换和适配,其次是资源管理的协调,Hadoop 的 YARN 与 Spark 的资源管理器需要有效协同,以确保资源的合理分配和利用,版本兼容性也是一个关键问题,不同版本的 Hadoop 和 Spark 可能存在不兼容的情况,需要谨慎选择和配置。

面对这些困难并非毫无办法,对于数据格式的兼容性问题,可以通过开发中间转换工具或者使用统一的数据格式标准来解决,在资源管理协调方面,深入了解 YARN 和 Spark 资源管理器的工作原理,进行合理的配置和优化是关键,而针对版本兼容性,及时关注官方文档和社区动态,选择经过验证的稳定版本组合,并进行充分的测试是必要的。

要成功集成 Hadoop 与 Spark,还需要开发者具备扎实的技术功底和丰富的实践经验,不断学习和探索新的技术方案,结合实际业务需求进行优化和调整,才能充分发挥它们集成后的优势,为大数据处理带来更高的效率和价值。

参考来源:大数据技术相关研究文献及技术论坛。