Hadoop 与 Spark 资源分配的关键问题探讨

在当今的大数据处理领域,Hadoop 和 Spark 是两款备受瞩目的技术,它们的资源分配是否合理,一直是众多开发者和企业关注的焦点。

Hadoop 和 Spark 作为大数据处理的重要工具,其资源分配的合理性直接影响到系统的性能和效率,如果资源分配不当,可能会导致任务执行缓慢、资源浪费甚至系统崩溃等问题。

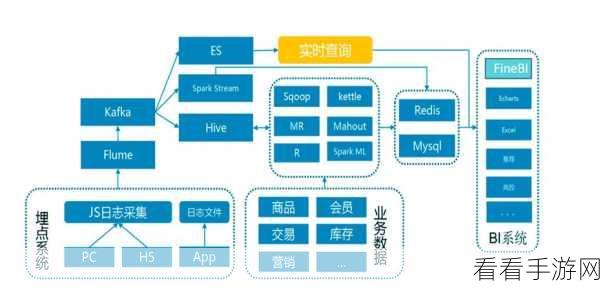

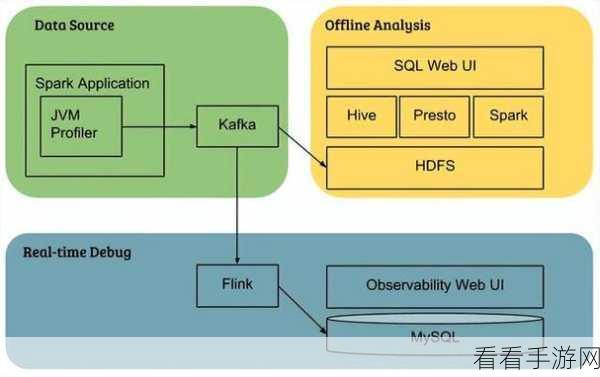

要深入探讨 Hadoop 与 Spark 资源分配的合理性,我们首先需要了解它们的工作原理和资源需求特点,Hadoop 主要用于大规模数据的存储和批处理,对内存和磁盘 I/O 资源有较高要求,而 Spark 则更侧重于内存计算和实时处理,对内存和 CPU 资源的依赖较大。

在实际应用中,资源分配的合理性还受到多种因素的影响,数据量的大小、任务的复杂度、集群的规模和硬件配置等,对于大规模数据处理任务,合理分配资源可以显著提高处理效率,减少处理时间。

为了实现 Hadoop 与 Spark 资源的合理分配,我们可以采取一些策略和方法,可以通过监控系统资源的使用情况,实时调整资源分配,根据任务的特点和优先级,预先进行资源规划和分配。

还可以利用一些工具和技术来优化资源分配,使用资源管理框架如 YARN 来统一管理和分配资源,或者采用自动伸缩技术根据负载动态调整资源。

Hadoop 与 Spark 资源分配的合理性是一个复杂但至关重要的问题,只有充分了解它们的特点和需求,并采取有效的策略和方法,才能实现资源的优化配置,提高大数据处理的效率和性能。

文章参考来源:大数据处理相关技术文献和实践经验总结。