探索大数据,Hadoop 与 Spark 的完美整合之道

在当今数字化时代,大数据技术的重要性日益凸显,Hadoop 和 Spark 作为大数据领域的关键技术,如何实现它们的整合成为众多开发者和企业关注的焦点。

Hadoop 以其强大的分布式存储和处理能力而闻名,能够处理海量的数据,而 Spark 则凭借其高效的内存计算和快速的处理速度备受青睐,将二者整合,可以充分发挥各自的优势,提升大数据处理的效率和性能。

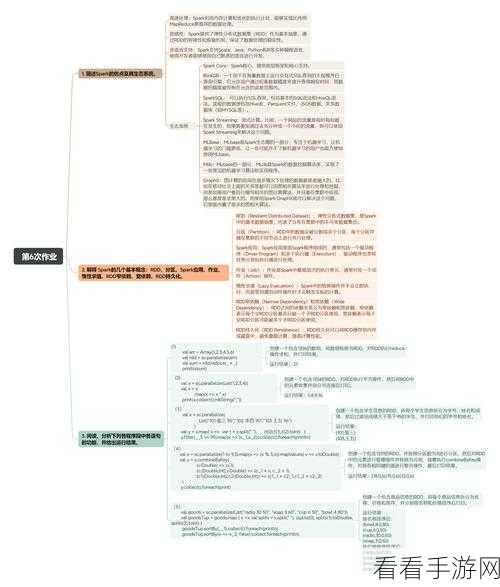

要实现 Hadoop 和 Spark 的整合,需要了解它们的架构和特点,Hadoop 主要由 HDFS(分布式文件系统)和 MapReduce(计算框架)组成,而 Spark 则包括 Spark Core、Spark SQL、Spark Streaming 等组件,在整合过程中,需要合理配置资源,确保两者能够协同工作。

数据的迁移和转换是整合中的关键环节,需要将 Hadoop 中的数据有效地导入到 Spark 中进行处理,同时也要保证数据的一致性和完整性,这可能涉及到数据格式的转换、数据分区的调整等操作。

任务的调度和管理也至关重要,要根据业务需求和数据特点,合理分配 Hadoop 和 Spark 的任务,以达到最优的处理效果,还需要监控整个整合系统的运行状态,及时发现和解决可能出现的问题。

Hadoop 和 Spark 的整合并非一蹴而就,需要综合考虑多个因素,并通过不断的实践和优化来实现,只有充分发挥两者的优势,才能在大数据处理中取得更好的成果。

参考来源:大数据技术相关专业书籍及权威技术论坛