深度探索大数据,Hadoop 与 Spark 的超强数据处理秘籍

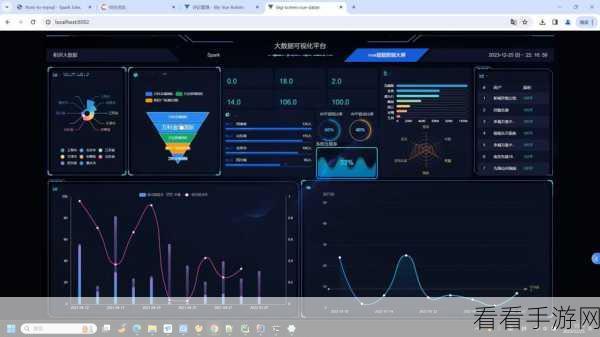

大数据时代,数据处理能力成为关键,Hadoop 和 Spark 作为大数据处理领域的两大核心技术,展现出了强大的实力。

Hadoop 以其分布式存储和并行计算的特点,为海量数据的处理提供了坚实基础,它能够将大规模数据分散存储在多个节点上,并通过并行计算框架 MapReduce 实现高效的数据处理。

Spark 则凭借其内存计算的优势,在数据处理速度上实现了巨大突破,它不仅支持多种数据格式,还提供了丰富的 API 和库,方便开发者进行数据处理和分析。

在实际应用中,Hadoop 适合处理大规模的离线数据,例如日志分析、数据仓库构建等,而 Spark 更适用于实时数据处理、交互式查询和机器学习等场景。

要充分发挥 Hadoop 和 Spark 的数据处理能力,需要合理配置资源,包括内存、CPU、存储等方面的优化,以确保系统的性能和稳定性。

掌握数据处理的算法和技巧也是至关重要的,选择合适的数据结构、优化数据读取和写入等,都能显著提升数据处理的效率。

对于大规模数据的处理,还需要考虑数据的分区和分布策略,以减少数据的传输和提高计算的并行度。

Hadoop 和 Spark 为大数据处理提供了强大的工具和技术支持,通过合理的应用和优化,能够充分挖掘数据的价值,为企业和组织带来巨大的收益。

参考来源:相关大数据技术书籍及权威技术论坛。