Python 与 Spark 数据分析的奇妙之旅

Python 在数据分析领域可谓是一把利剑,而 Spark 则是处理大规模数据的强大工具,当 Python 与 Spark 相结合,将为数据分析带来全新的可能。

要想在数据分析中充分发挥 Python 和 Spark 的优势,首先需要对两者有深入的了解,Python 作为一种高级编程语言,具有简洁易懂、丰富的库和强大的扩展性,而 Spark 则是一个快速、通用的大数据处理框架,能够高效地处理海量数据。

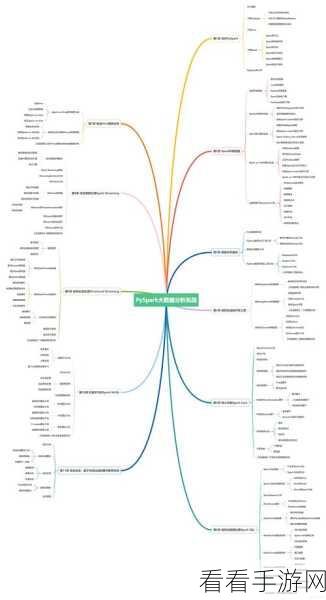

在实际操作中,配置合适的开发环境至关重要,需要安装 Python 相关的依赖库,如 PySpark,并确保 Spark 集群的正常运行,就是掌握数据的读取和写入,通过 PySpark 可以轻松地从各种数据源读取数据,如 CSV 文件、数据库等,并将处理后的数据写入到指定的位置。

数据处理是核心环节,利用 Spark 的强大功能,进行数据清洗、转换和聚合等操作,去除重复数据、填充缺失值、对数据进行分组计算等。

在数据分析中,可视化也是不可或缺的一部分,通过 Python 的可视化库,如 Matplotlib、Seaborn 等,可以将分析结果以直观的图表形式展示出来,让数据更易于理解和解读。

熟练运用 Python 和 Spark 进行数据分析,需要不断的学习和实践,只有在实际项目中积累经验,才能更好地驾驭这一强大的组合,为数据分析工作带来更高的效率和更准确的结果。

文章参考来源:数据分析相关书籍及网络技术论坛。