Python Spark 数据分析,性能提升的关键秘籍

在当今数字化时代,数据分析成为企业和组织决策的重要依据,Python Spark 作为一种强大的数据分析工具,其性能表现直接影响着数据分析的效率和质量。

Python Spark 数据分析性能的优劣受到多种因素的影响,数据的规模和复杂度是首要因素,当处理海量、复杂的数据时,系统的计算资源和算法选择就显得至关重要,代码的优化程度也会对性能产生显著影响,编写高效、简洁的代码能够充分发挥 Python Spark 的优势,提高数据处理速度。

要提升 Python Spark 数据分析的性能,合理配置计算资源是关键,根据数据量和计算需求,调整内存、CPU 核心数等参数,确保系统能够高效运行,选择合适的数据结构和算法同样重要,对于大规模数据的排序和聚合操作,采用合适的算法可以大大减少计算时间。

对代码进行优化也是必不可少的,避免不必要的重复计算,使用向量化操作和并行计算等技术,能够显著提高代码的执行效率,及时清理不再使用的内存,避免内存泄漏,也有助于提升性能。

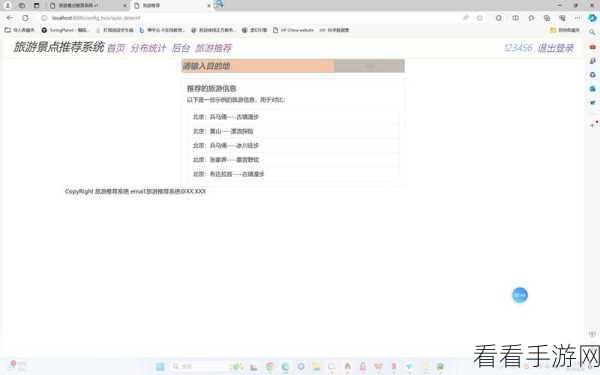

在实际应用中,不断进行性能测试和调优是必不可少的步骤,通过对不同场景和数据的测试,发现性能瓶颈,并针对性地进行优化,才能使 Python Spark 数据分析性能达到最佳状态。

要充分发挥 Python Spark 在数据分析中的强大性能,需要综合考虑数据特点、计算资源配置、算法选择和代码优化等多个方面,只有不断探索和实践,才能在数据分析领域取得出色的成果。

参考来源:行业内相关技术文档及专家经验分享