Python 爬虫 requests 高效获取网页内容秘籍

Python 爬虫中的 requests 库是获取网页内容的强大工具,掌握其使用方法能让我们在数据采集的道路上如虎添翼。

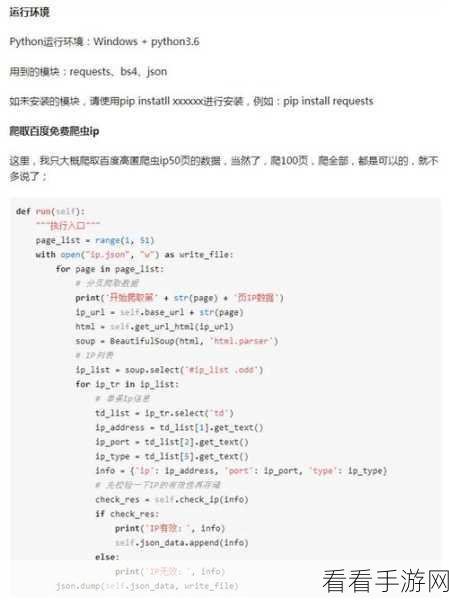

在实际应用中,requests 库的使用并非一蹴而就,需要我们深入了解其原理和技巧,要确保已经正确安装了 requests 库,可以通过在命令行中输入相关指令来进行安装。

我们要明确获取网页内容的基本步骤,发送请求是第一步,这就像是向目标网站发出“拜访”的请求,接收响应并处理,响应中包含了我们所需的网页内容,但可能需要进行一些解析和提取工作。

在发送请求时,要注意设置正确的请求方法,如 GET、POST 等,这取决于具体的网页要求和我们的需求,还可以设置请求头,模拟真实的浏览器行为,避免被网站识别为爬虫而遭到封禁。

对于响应的处理,需要根据返回的数据格式进行相应的操作,如果是 HTML 格式,可以使用 BeautifulSoup 等库进行解析;如果是 JSON 格式,则可以直接进行数据提取。

处理异常情况也是至关重要的,网络连接异常、服务器错误等都可能导致获取网页内容失败,在代码中要添加适当的错误处理机制,以保证程序的稳定性和可靠性。

熟练掌握 Python 爬虫 requests 库获取网页内容的方法,需要不断地实践和探索,只有在实际操作中积累经验,才能更好地应对各种复杂的情况,获取到我们所需的有价值的数据。

参考来源:相关技术文档及个人实践经验总结