深度解析,Spark SortBy 应对海量大数据的技巧

在当今数字化时代,数据量呈现爆炸式增长,如何高效处理大数据成为了众多领域面临的关键问题,而 Spark 作为一款强大的大数据处理框架,其 SortBy 操作在处理大规模数据时具有重要作用。

Spark SortBy 处理大数据量并非易事,需要综合考虑多种因素,首先是数据分布的特点,不同的数据分布情况会对 SortBy 的性能产生显著影响,如果数据分布较为均匀,那么排序的效率可能相对较高;但若是数据存在严重的倾斜,就可能导致某些节点的负载过重,从而影响整体性能。

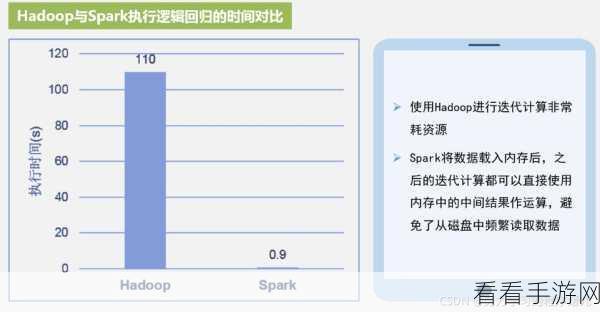

内存的使用和管理,在进行 SortBy 操作时,需要合理分配内存资源,如果内存不足,可能会导致频繁的磁盘读写,极大地降低处理速度,提前预估数据量,并根据实际情况调整内存配置至关重要。

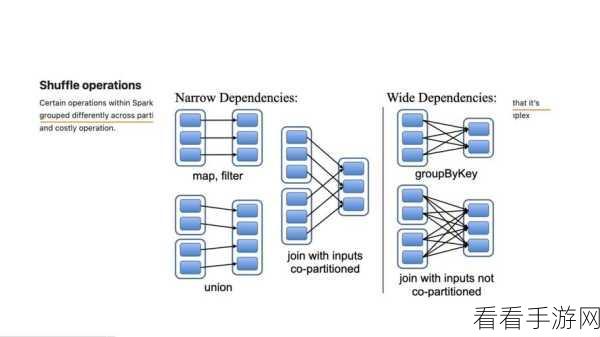

选择合适的分区策略也是提升性能的关键,合适的分区可以使数据在各个节点上更加均衡地分布,减少数据的传输和计算开销。

优化算法和参数设置同样不可忽视,通过对 Spark 的一些参数进行精细调整,比如调整排序的并行度、缓冲区大小等,可以进一步提高 SortBy 的性能。

对于大规模数据的处理,还需要考虑硬件设施的支持,强大的计算资源和高速的存储设备能够为 Spark SortBy 提供更有力的保障。

要想让 Spark SortBy 在处理大数据量时发挥出最佳性能,需要从多个方面进行综合考虑和优化,只有这样,才能在大数据的海洋中畅游,快速而准确地获取所需的信息。

参考来源:相关技术文档及行业研究报告。