深入探究,Spark SortBy 数据分区的秘诀与技巧

Spark 中的 SortBy 操作在处理大规模数据时起着至关重要的作用,而其数据分区策略更是影响性能的关键因素。

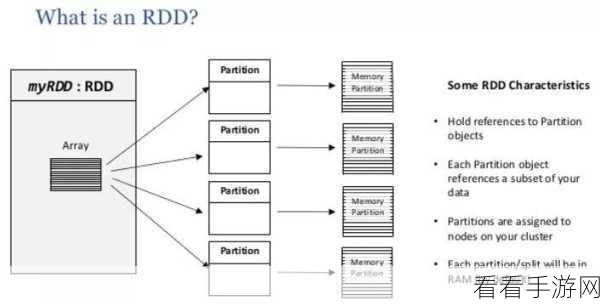

SortBy 数据分区并非简单的操作,它涉及到多个复杂的环节和技术要点,要理解 Spark SortBy 如何进行数据分区,首先需要明白 Spark 的基本架构和工作原理,Spark 是一个强大的分布式计算框架,它通过将数据分布在多个节点上进行并行处理,从而实现高效的计算。

在数据分区过程中,Spark 会根据指定的排序键对数据进行划分,这意味着相同排序键的值会被分配到同一个分区中,以便后续的排序操作能够更加高效地进行,分区的数量和划分方式会直接影响到数据处理的性能和效率。

为了实现最佳的数据分区效果,开发者需要根据数据的特点和处理需求来合理设置相关参数,调整分区数量可以避免数据倾斜,确保各个分区的负载均衡,从而提高整个系统的性能。

还需要考虑数据的分布情况和排序键的特性,如果数据本身存在较大的偏差或者排序键的分布不均匀,可能需要采用特殊的分区策略来优化处理过程。

深入理解 Spark SortBy 的数据分区机制,对于优化 Spark 应用程序的性能至关重要,只有掌握了这些技巧和方法,才能在处理大规模数据时游刃有余,充分发挥 Spark 的强大能力。

文章参考来源:Spark 官方文档及相关技术论坛的讨论。