Python Scrapy 爬虫编写秘籍,从入门到精通

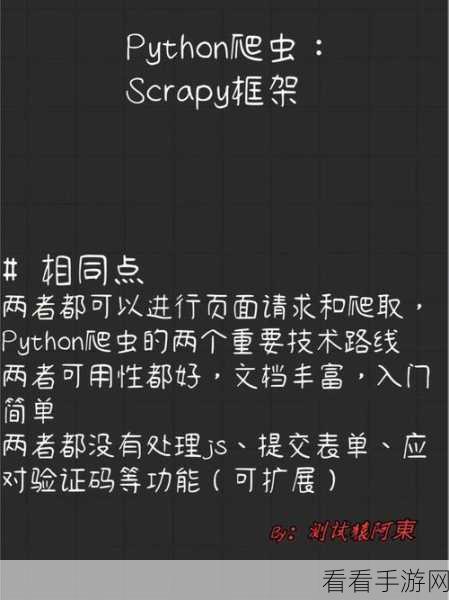

Python 的 Scrapy 框架为我们提供了强大而高效的爬虫工具,掌握如何运用它来编写爬虫,能够让我们在数据获取的道路上如虎添翼。

Scrapy 框架具有众多优势,它的架构设计清晰,易于扩展和定制,它提供了丰富的中间件和扩展机制,让开发者可以根据具体需求灵活调整爬虫的行为。

要开始编写 Python Scrapy 爬虫,首先需要了解其基本概念和组件,Scrapy 中的核心组件包括引擎、调度器、下载器、爬虫、管道等,引擎负责协调各个组件的工作流程,调度器管理请求队列,下载器负责下载网页内容,爬虫负责解析网页并提取数据,管道则用于处理和存储爬取到的数据。

就是实际的代码编写环节,我们需要创建一个 Scrapy 项目,并在项目中定义爬虫类,在爬虫类中,通过定义 start_requests 方法来指定起始的 URL 和请求方式,使用 parse 方法对下载的网页进行解析和数据提取。

在数据提取过程中,可以使用 XPath 或 CSS 选择器来定位和提取所需的元素,要注意处理网页中的各种异常情况,如页面不存在、网络错误等,以确保爬虫的稳定性和可靠性。

还可以通过设置请求头、处理验证码、使用代理等方式来应对一些复杂的网站反爬虫机制。

掌握 Python Scrapy 爬虫的编写需要不断地实践和探索,通过深入理解其原理和机制,并结合实际项目需求进行开发,相信您一定能够成为爬虫高手,轻松获取所需的数据。

文章参考来源:Python 官方文档及相关技术论坛。

仅供参考,您可以根据实际需求进行调整和修改。