Hive Parquet 处理多表连接的秘籍大揭秘

Hive Parquet 中多表连接的处理是一个复杂但关键的技术问题,在大数据处理领域,掌握有效的多表连接方法对于提升数据处理效率和准确性至关重要。

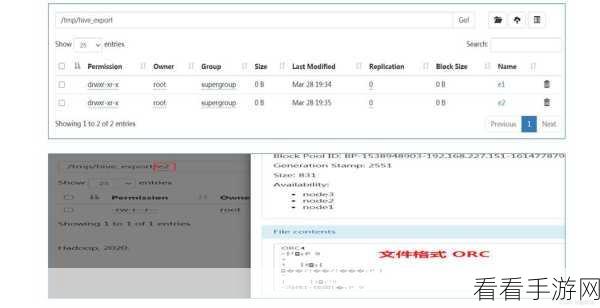

要理解 Hive Parquet 中的多表连接,首先需要明确其基本概念和工作原理,Hive 是基于 Hadoop 的一种数据仓库工具,而 Parquet 是一种高效的列式存储格式,当涉及多表连接时,数据的存储方式和查询优化策略都会对处理效果产生影响。

在实际应用中,选择合适的连接方式至关重要,常见的连接方式包括内连接、外连接、左连接和右连接等,不同的连接方式适用于不同的业务场景和数据特点,内连接返回两个表中匹配的行,而外连接则会返回包括不匹配行在内的更多数据。

优化多表连接的性能也是关键的一环,这包括合理设置分区、索引以及调整相关的配置参数,通过对表进行分区,可以减少数据扫描的范围,提高查询效率,而合理创建索引能够加快数据的检索速度。

还需要注意数据的分布和倾斜情况,如果数据分布不均匀或者存在倾斜,可能会导致某些节点负载过高,影响整个连接处理的性能,针对这种情况,需要采取数据均衡或者重新分布的策略。

熟练掌握 Hive Parquet 多表连接的处理技巧,需要对其原理有深入理解,选择合适的连接方式,优化性能,并注意数据的分布情况,只有这样,才能在大数据处理中实现高效准确的多表连接操作。

文章参考来源:大数据处理相关技术文档和实践经验。