深入探究,mllib spark 文档的完整性究竟如何?

在当今的大数据和机器学习领域,mllib spark 无疑是备受关注的重要工具,关于其文档是否完善,一直是众多开发者和研究者心中的疑问。

mllib spark 文档对于使用者来说至关重要,完善的文档能够帮助开发者更快速地理解和掌握相关技术,提高开发效率,减少不必要的错误和时间浪费,但如果文档存在缺陷或不完善之处,可能会给使用者带来诸多困扰,甚至影响项目的进展。

如何评估 mllib spark 文档的完善程度呢?这需要从多个方面进行考量。

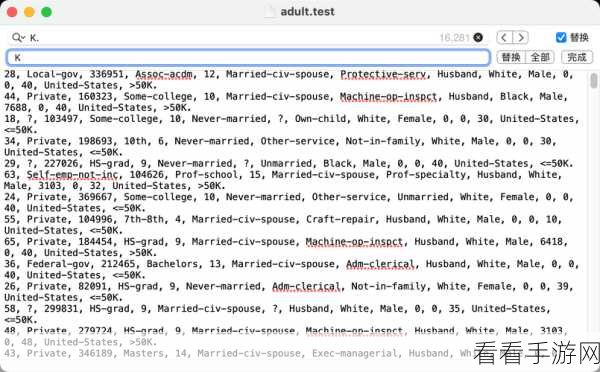

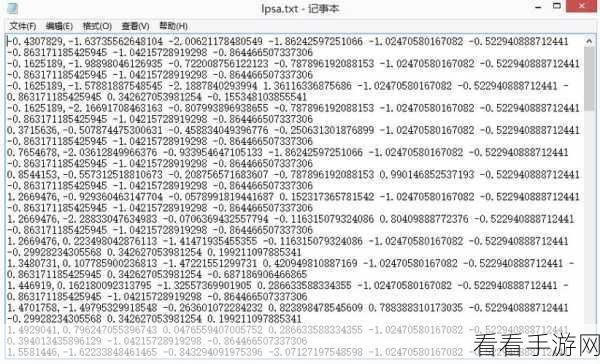

覆盖范围是一个关键因素,它是否涵盖了 mllib spark 的所有主要功能和特性?对于一些较为复杂和高级的应用场景,是否有详细的说明和示例?如果文档在内容覆盖上存在明显的缺失,那么就很难满足使用者的需求。

文档的清晰度和易理解性也不容忽视,表述是否简洁明了,逻辑是否清晰,对于初学者来说能否轻松读懂并按照文档进行操作?如果文档的表述晦涩难懂,会让使用者感到困惑,增加学习的难度。

文档的更新频率也能反映其完善程度,随着技术的不断发展和更新,mllib spark 也在不断演进,如果文档不能及时跟上这些变化,提供最新的信息和指导,那么其价值也会大打折扣。

还需要关注文档中的错误和不准确之处,错误的信息可能会导致使用者做出错误的决策和操作,带来严重的后果。

评估 mllib spark 文档的完善程度需要综合考虑内容覆盖、清晰度、更新频率以及准确性等多个方面,只有在这些方面都表现出色的文档,才能真正为使用者提供有效的帮助和支持。

文章参考来源:行业内相关讨论及开发者经验分享。