探究 Kafka Export 数据导出的稳定性

Kafka Export 数据导出一直是众多开发者和数据处理人员关注的焦点,其稳定性对于数据的有效传输和处理至关重要。

Kafka 作为一种强大的分布式消息队列系统,在数据处理和传输方面发挥着重要作用,而 Kafka Export 则负责将数据从 Kafka 中导出到其他系统或存储介质,在实际应用中,人们常常会对其导出数据的稳定性产生疑问。

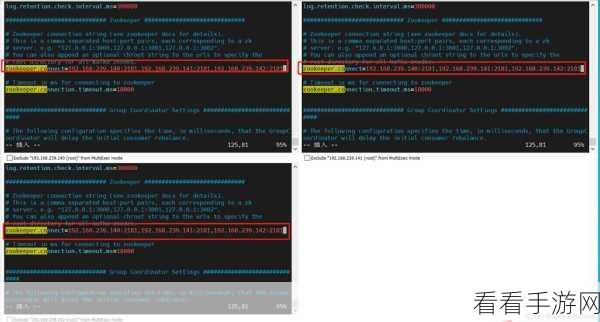

要评估 Kafka Export 数据导出的稳定性,需要从多个方面进行考量,首先是网络环境的稳定性,如果网络存在波动、延迟或者丢包等问题,都可能影响数据导出的连贯性和完整性,其次是系统资源的分配,包括服务器的 CPU、内存、磁盘 I/O 等资源,如果资源不足或者分配不合理,也会导致数据导出出现中断或者错误,数据量的大小和数据的复杂性也会对稳定性产生影响,大量复杂的数据可能会增加导出的时间和处理难度,从而增加不稳定的风险。

为了确保 Kafka Export 数据导出的稳定性,我们可以采取一些有效的措施,优化网络环境是关键之一,确保网络的稳定和高速,减少数据传输中的干扰,合理分配系统资源,根据数据量和处理需求,合理配置服务器的硬件资源,避免出现资源瓶颈,对数据进行预处理和优化,减少不必要的数据量和复杂性,提高导出的效率和稳定性。

定期的监控和测试也是必不可少的,通过监控数据导出的过程,及时发现潜在的问题,并进行针对性的优化和调整,进行定期的压力测试和模拟故障测试,提前发现可能出现的不稳定情况,并制定相应的应对策略。

Kafka Export 数据导出的稳定性是一个需要综合考虑和精心优化的问题,只有从多个方面入手,采取有效的措施,才能确保数据导出的稳定可靠,为数据处理和应用提供有力的支持。

文章参考来源:相关技术论坛及专业书籍。