Python 爬虫 requests 应对反爬机制的秘籍

在当今数字化时代,网络数据的获取成为众多开发者和研究者关注的焦点,而 Python 爬虫中的 requests 库在数据采集过程中,经常会遭遇反爬机制的阻碍,如何巧妙地处理这一难题,成为了提升爬虫效率和成功率的关键。

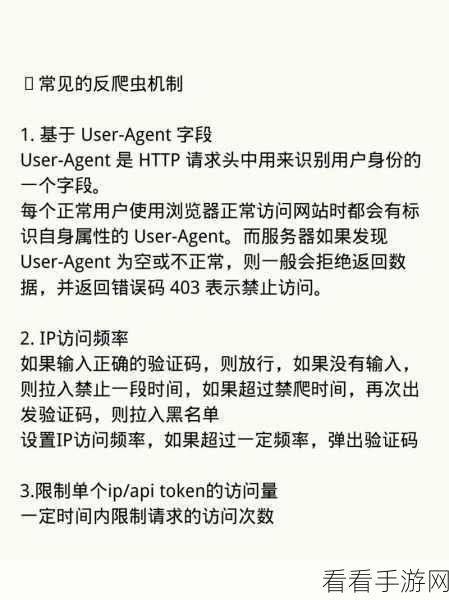

反爬机制是网站为了保护自身数据和资源而设置的屏障,常见的反爬手段包括限制访问频率、检测请求头信息、验证码验证等。

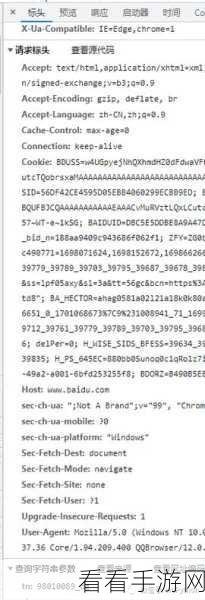

要处理反爬机制,第一步是模拟真实用户的行为,这意味着我们需要设置合理的请求头信息,包括 User-Agent、Referer 等,使其看起来更像是正常的用户访问。

控制访问频率至关重要,避免过于频繁地发送请求,以免被网站识别为爬虫,可以通过设置随机的时间间隔来模拟人类的访问习惯。

对于一些需要验证码验证的网站,我们可以考虑使用第三方的验证码识别服务,或者通过手动输入验证码来解决。

使用代理 IP 也是一种有效的方法,当一个 IP 被封禁时,可以切换到其他可用的 IP 继续访问。

在实际操作中,还需要不断地测试和优化策略,根据网站的反爬机制的变化,及时调整我们的处理方式。

处理 Python 爬虫 requests 的反爬机制需要综合运用多种技术和策略,并且要有耐心和细心,不断探索和尝试,才能在合法合规的前提下获取到所需的数据。

参考来源:相关技术论坛及专业书籍。