在当今数字化的时代,数据传输的监控至关重要,尤其是在 syslog kafka 这一领域,对于许多开发者和运维人员来说,如何有效地进行数据传输监控是一个关键问题。

想要深入了解 syslog kafka 的数据传输监控,我们首先得明白它的工作原理,syslog 是一种用于在网络中传递日志信息的标准协议,而 Kafka 则是一个分布式的消息队列系统,当它们结合在一起时,能够实现高效的数据传输,但同时也带来了监控的挑战。

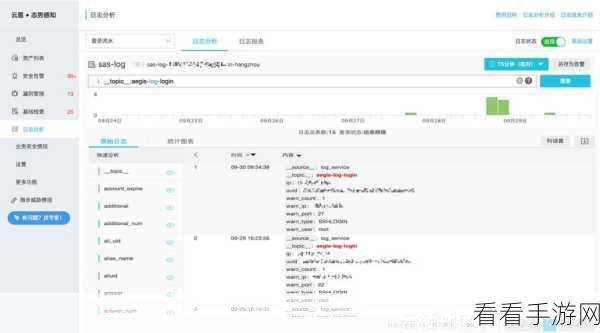

监控 syslog kafka 数据传输的重点在于实时监测数据的流动情况,这包括对数据的发送、接收、处理和存储等环节进行全面的跟踪,通过设置合适的监控指标,如数据传输速率、延迟、丢包率等,可以及时发现潜在的问题。

为了实现有效的监控,选择合适的工具和技术是必不可少的,市面上有许多专门用于监控 syslog kafka 数据传输的工具,它们具备强大的功能,能够帮助我们获取详细的监控数据和分析报告。

建立完善的预警机制也是至关重要的,当监控指标超过预设的阈值时,能够及时发出警报,让相关人员能够迅速采取措施,避免问题的进一步扩大。

定期对监控数据进行分析和总结也是优化数据传输监控的重要环节,通过分析历史数据,可以发现潜在的规律和趋势,从而提前做好预防和优化工作。

syslog kafka 的数据传输监控是一个复杂但又至关重要的任务,只有通过深入理解其工作原理,选择合适的工具和技术,建立完善的预警机制,并定期进行数据分析,才能确保数据传输的稳定和可靠。

文章参考来源:相关技术文档及行业研究报告。