在当今数字化时代,数据的实时处理和分发变得至关重要,Flink 和 Kafka 作为强大的工具,在数据处理领域发挥着关键作用,如何实现它们之间的数据实时分发呢?

要理解 Flink 和 Kafka 数据实时分发,我们首先得明晰它们各自的特点,Flink 是一个出色的流处理框架,具备高吞吐、低延迟和精确一次的处理能力,而 Kafka 则是分布式的消息队列,以其高可靠、可扩展的特性而闻名。

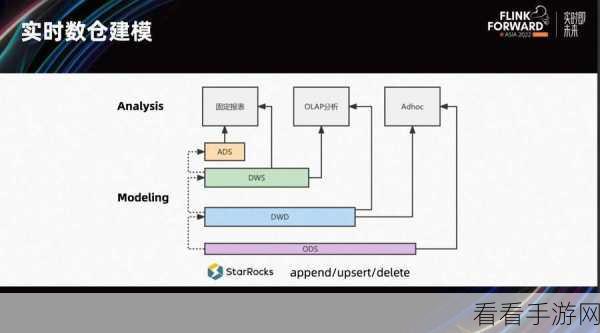

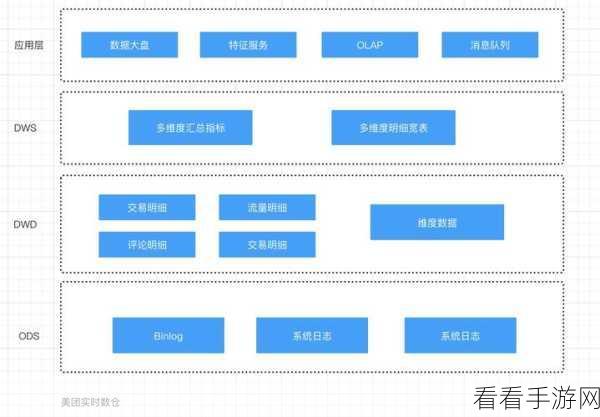

实现 Flink 和 Kafka 的数据实时分发,关键在于配置正确的连接器,通过合适的连接器设置,能够确保数据在两者之间顺畅流动,数据格式的转换也是不容忽视的环节,不同的数据格式可能需要进行相应的转换处理,以保证数据在分发过程中的一致性和可用性。

在实际应用中,还需要考虑性能优化的问题,合理调整 Flink 的并行度、优化 Kafka 的分区策略等,都能显著提升数据实时分发的效率。

监控和错误处理也是必不可少的,建立有效的监控机制,能够及时发现分发过程中的异常情况,并采取相应的措施进行处理,保障系统的稳定运行。

要成功实现 Flink 和 Kafka 的数据实时分发,需要综合考虑多个方面的因素,从连接器配置、数据格式转换,到性能优化、监控和错误处理,每一个环节都至关重要,只有精心设计和优化,才能充分发挥它们的优势,为数据处理带来高效和可靠的支持。

参考来源:相关技术文档及行业实践经验。