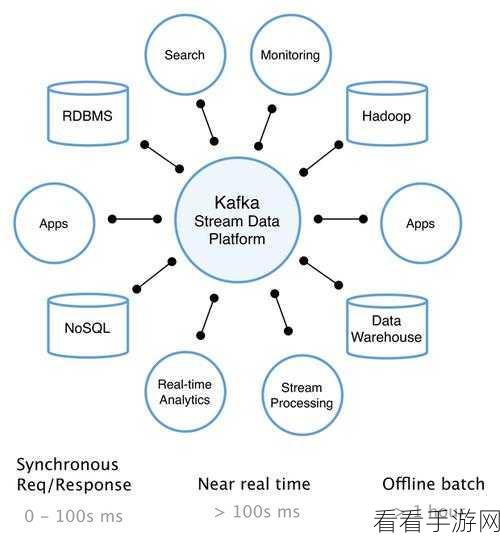

Stream Kafka 在数据处理领域扮演着至关重要的角色,其数据实时聚合功能更是备受关注,如何有效地实现这一功能呢?

要了解 Stream Kafka 数据实时聚合,首先得清楚其工作原理,Stream Kafka 基于分布式架构,能够高效地接收和处理大量的实时数据,它通过特定的机制对数据进行分类和整理,为后续的聚合操作奠定基础。

实现数据实时聚合,关键在于合理配置相关参数,调整缓冲区大小、设置数据处理的并发度等,这些参数的优化能够显著提升聚合的效率和准确性。

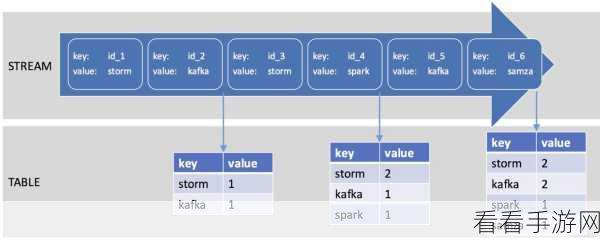

选择合适的聚合算法也是必不可少的,不同的算法在处理不同类型和规模的数据时,表现出的性能差异较大,常见的聚合算法有求和、平均值、最大值、最小值等,根据实际需求进行选择。

数据的预处理也能为实时聚合带来积极影响,在数据进入 Stream Kafka 之前,对其进行清洗、筛选和转换,去除无效和冗余的数据,能够减轻后续聚合的负担,提高处理速度。

在实际应用中,还需要不断进行测试和优化,通过模拟不同的业务场景,观察聚合效果,及时发现并解决可能出现的问题,从而确保系统的稳定性和可靠性。

掌握 Stream Kafka 数据实时聚合并非一蹴而就,需要综合考虑多个因素,并在实践中不断探索和改进。

文章参考来源:相关技术文档及行业研究报告。