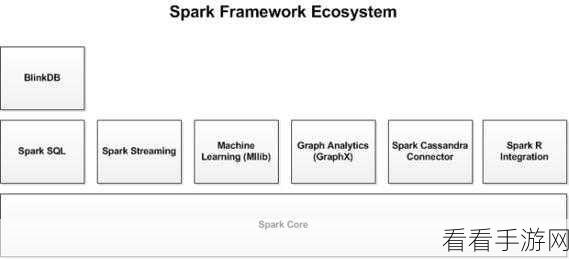

在当今数字化时代,大数据的处理成为众多领域的关键问题,Spark Ling 作为一款强大的工具,为处理大数据集提供了有效的解决方案。

Spark Ling 之所以能够在大数据处理领域表现出色,是因为其具备一系列独特的特性和优势,它拥有高效的分布式计算框架,能够将大规模数据分布在多个节点上并行处理,从而大大提高了处理速度,它提供了丰富的 API 和库,使得数据的读取、转换和分析变得更加便捷和灵活,Spark Ling 还支持多种数据格式,包括 CSV、JSON、Parquet 等,能够轻松应对不同类型的数据。

要想充分发挥 Spark Ling 处理大数据集的能力,以下是一些关键的步骤和技巧。

第一步是数据的准备和清洗,在处理大数据集之前,需要对数据进行清理和预处理,去除重复、缺失和异常值等,这可以通过 Spark Ling 的 DataFrame API 来实现,使用函数如 dropDuplicates()、fillna() 等。

第二步是选择合适的算法和操作,根据数据的特点和处理需求,选择合适的 Spark Ling 算法和操作,如果需要进行数据聚合,可以使用 groupBy() 和 agg() 函数;如果需要进行数据过滤,可以使用 filter() 函数。

第三步是优化性能,为了提高 Spark Ling 的处理性能,可以调整一些参数,如内存分配、并行度等,还可以使用缓存(cache)和持久化(persist)机制,将经常使用的数据存储在内存中,以减少重复计算。

在实际应用中,还需要注意一些常见的问题和错误,数据倾斜可能导致某些节点的处理时间过长,影响整体性能,这时可以通过数据重分布、使用加盐等方法来解决。

掌握 Spark Ling 处理大数据集的方法和技巧,能够为数据分析和处理带来更高的效率和更好的效果,希望以上攻略对您有所帮助。

文章参考来源:相关技术文档及个人实践经验总结。