本文深入探讨了Lora微调技术的最新进展,揭秘如何通过学习少量数据实现高效记忆,并全面解析超参设置的技巧。

近年来,随着人工智能技术的飞速发展,Lora微调技术在游戏领域的应用日益广泛,这一技术不仅能够大幅提升模型的训练效率,还能在保持模型性能的同时,显著减少所需的数据量,一项关于Lora微调的新探索引起了业界的广泛关注——通过巧妙的超参设置,模型能够在学习少量数据的情况下,依然保持出色的记忆能力,本文将详细解析这一技术的核心要点,为手游开发者提供实用的参考。

中心句:Lora微调技术概述及其在手游领域的应用价值。

Lora微调,即Low-Rank Adaptation,是一种针对预训练大模型的轻量级调整方法,它通过在预训练模型的基础上,引入一个低秩的矩阵来捕捉任务特定的信息,从而实现模型的快速适应,在手游领域,Lora微调技术具有显著的应用价值,它能够大幅缩短新游戏或新功能的开发周期,因为开发者无需从头开始训练模型,只需对预训练模型进行微调即可,Lora微调还能有效缓解数据稀缺的问题,使得模型在有限的数据下也能表现出色。

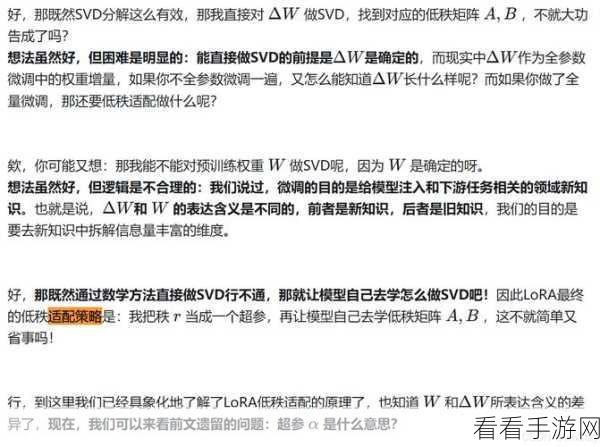

中心句:Lora微调技术如何实现“学得少记得牢”。

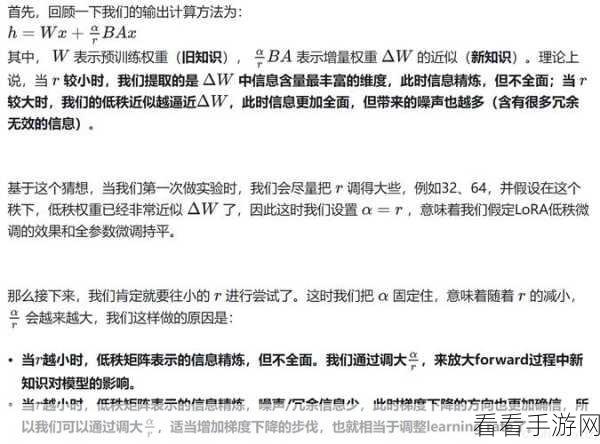

Lora微调技术之所以能够实现“学得少记得牢”,关键在于其独特的超参设置,在微调过程中,开发者需要仔细调整多个超参数,包括学习率、正则化系数、Lora矩阵的秩等,这些超参数的选择对模型的性能有着至关重要的影响,适当降低学习率可以确保模型在微调过程中不会过度偏离预训练状态,从而保持其泛化能力;而增加Lora矩阵的秩则有助于模型捕捉更多的任务特定信息,提高其在少量数据下的表现。

中心句:全面解析Lora微调技术的超参设置技巧。

在进行Lora微调时,超参设置的技巧至关重要,以下是一些实用的建议:

1、学习率的调整:学习率是决定模型更新速度的关键参数,在微调过程中,建议采用较小的学习率,以避免模型在少量数据下发生过拟合,可以通过学习率衰减策略来逐步降低学习率,进一步提高模型的稳定性。

2、正则化系数的选择:正则化系数用于控制模型的复杂度,防止其过拟合,在Lora微调中,适当增加正则化系数有助于提升模型的泛化能力,过高的正则化系数也可能导致模型欠拟合,因此需要仔细权衡。

3、Lora矩阵的秩:Lora矩阵的秩决定了模型能够捕捉的任务特定信息的数量,在数据稀缺的情况下,较低的秩可能更有助于模型保持泛化能力;而在数据充足的情况下,较高的秩则可能带来更好的性能提升。

参考来源:本文基于最新的Lora微调技术研究文献及业界实践案例进行撰写。

最新问答:

1、问:Lora微调技术是否适用于所有类型的手游?

答:Lora微调技术主要适用于基于预训练大模型的手游开发,对于小型或特定领域的游戏,可能需要考虑其他方法。

2、问:在进行Lora微调时,如何确定最佳的超参设置?

答:最佳的超参设置通常需要通过实验来确定,开发者可以采用网格搜索、随机搜索或贝叶斯优化等方法来寻找最优的超参组合。

3、问:Lora微调技术能否替代传统的模型训练方法?

答:Lora微调技术并不能完全替代传统的模型训练方法,它更多地是一种补充手段,用于在有限的数据和计算资源下快速适应新任务,对于复杂或全新的游戏场景,仍然需要从头开始训练模型。