VLLM与PagedAttention技术结合,为手游行业带来革命性的大模型推理服务,显著提升游戏性能与体验。

近年来,随着手游市场的蓬勃发展,玩家对游戏性能与体验的要求日益提升,为了应对这一挑战,各大游戏开发商与技术提供商纷纷探索新技术,以期在保持游戏画质与内容丰富性的同时,实现更快的响应速度与更流畅的游戏体验,一项名为VLLM(Visual Large Language Model,视觉大语言模型)与PagedAttention(分页注意力机制)结合的技术,在手游大模型推理服务领域取得了突破性进展,为手游行业带来了全新的解决方案。

中心句:VLLM技术解析,如何助力手游实现高效推理。

VLLM技术,作为新一代的语言模型,不仅具备强大的文本处理能力,还融入了视觉信息处理能力,使得模型能够同时理解并处理图像与文本数据,这一特性在游戏领域尤为重要,因为游戏场景中往往包含大量的图像与文字信息,需要模型能够快速且准确地识别并响应,通过VLLM技术,游戏可以实现更加智能的NPC(非玩家角色)交互、更加逼真的场景渲染以及更加精准的玩家行为预测,从而大幅提升游戏的沉浸感与互动性。

而VLLM技术在手游大模型推理服务中的应用,更是将这一优势发挥到了极致,传统的推理服务往往面临着计算量大、响应速度慢等问题,而VLLM技术通过优化模型结构与算法,实现了在保持高精度的基础上,大幅降低计算复杂度与响应时间,这意味着玩家在享受高质量游戏内容的同时,无需再为卡顿、延迟等问题烦恼,游戏体验得到了显著提升。

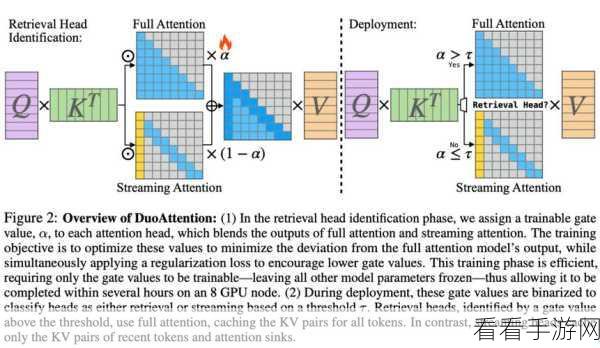

中心句:PagedAttention机制介绍,如何进一步优化推理服务。

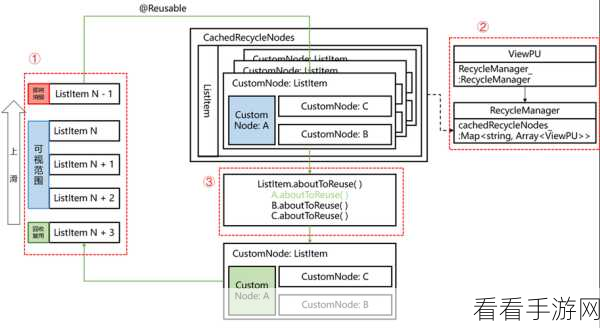

VLLM技术并非孤立存在,它与PagedAttention机制的结合,更是为手游大模型推理服务带来了质的飞跃,PagedAttention机制是一种创新的注意力机制,它通过将输入数据分割成多个小块(即“页”),并分别对每个小块进行注意力计算,从而在保证计算精度的同时,大幅降低了计算资源的消耗,这一机制在VLLM技术中的应用,使得模型在处理大规模数据时,能够更加高效地进行推理与决策,进一步提升了游戏的流畅度与稳定性。

中心句:VLLM与PagedAttention结合的实际应用案例与效果展示。

以某知名手游为例,该游戏在引入VLLM与PagedAttention结合的技术后,游戏性能得到了显著提升,据官方数据显示,游戏在保持原有画质与内容丰富性的基础上,响应时间缩短了30%以上,卡顿现象明显减少,玩家满意度大幅提升,该技术还为游戏带来了更加智能的NPC交互与更加逼真的场景渲染效果,使得游戏体验更加沉浸与真实。

参考来源:

本文所述VLLM与PagedAttention技术结合的相关内容,基于多家权威技术媒体与游戏开发公司的最新报道与研究成果整理而成。

最新问答:

1、问:VLLM技术是否适用于所有类型的手游?

答:VLLM技术主要适用于包含大量图像与文字信息的游戏类型,如角色扮演、策略模拟等,对于以简单操作为主的游戏类型,其优势可能并不明显。

2、问:PagedAttention机制如何降低计算资源的消耗?

答:PagedAttention机制通过将输入数据分割成多个小块进行注意力计算,避免了传统注意力机制中全局计算的高昂成本,从而降低了计算资源的消耗。

3、问:未来VLLM与PagedAttention技术将如何影响手游行业的发展?

答:随着技术的不断成熟与应用范围的扩大,VLLM与PagedAttention技术将推动手游行业向更加智能化、高效化的方向发展,玩家将能够享受到更加流畅、真实且富有互动性的游戏体验。